Apple i University of Washington przetestowali agentów AI na Gemini i ChatGPT, wniosek: technologia wciąż nie jest gotowa

Póki wszyscy aktywnie testujemy, jak AI może pisać eseje, kodować lub generować obrazy, badacze z Apple i University of Washington zadają sobie znacznie bardziej praktyczne pytanie: co się stanie, jeśli damy sztucznej inteligencji pełny dostęp do zarządzania aplikacjami mobilnymi? I najważniejsze — czy zrozumie konsekwencje swoich działań?

Co wiadomo

W badaniach zatytułowanych „Od interakcji do wpływu: w kierunku bezpieczniejszych agentów AI poprzez zrozumienie i ocenę wpływu operacji UI mobilnych”, opublikowanych na konferencji IUI 2025, zespół naukowców odkrył poważną lukę:

nowoczesne duże modele językowe (LLM) całkiem nieźle rozumieją interfejsy, ale katastrofalnie źle są świadome konsekwencji własnych działań w tych interfejsach.

Na przykład, dla AI naciśnięcie przycisku „Usuń konto” wygląda niemal tak samo jak „Polub”. Różnicę między nimi jeszcze trzeba mu wyjaśnić. Aby nauczyć maszyny rozróżniać znaczenie i ryzyko działań w aplikacjach mobilnych, zespół opracował specjalną taksonomię, która opisuje dziesięć podstawowych typów wpływu działań na użytkownika, interfejs, innych ludzi, a także bierze pod uwagę odwracalność, długoterminowe konsekwencje, weryfikację wykonania i nawet zewnętrzne konteksty (na przykład geolokalizację czy status konta).

Naukowcy stworzyli unikalny zestaw danych z 250 scenariuszami, w których AI musiał zrozumieć, które akcje są bezpieczne, które wymagają potwierdzenia, a które lepiej w ogóle nie wykonywać bez człowieka. W porównaniu z popularnymi zestawami danych AndroidControl i MoTIF, nowy zestaw jest znacznie bogatszy w sytuacje z realnymi konsekwencjami — od zakupów po zmianę haseł do zarządzania inteligentnymi domami.

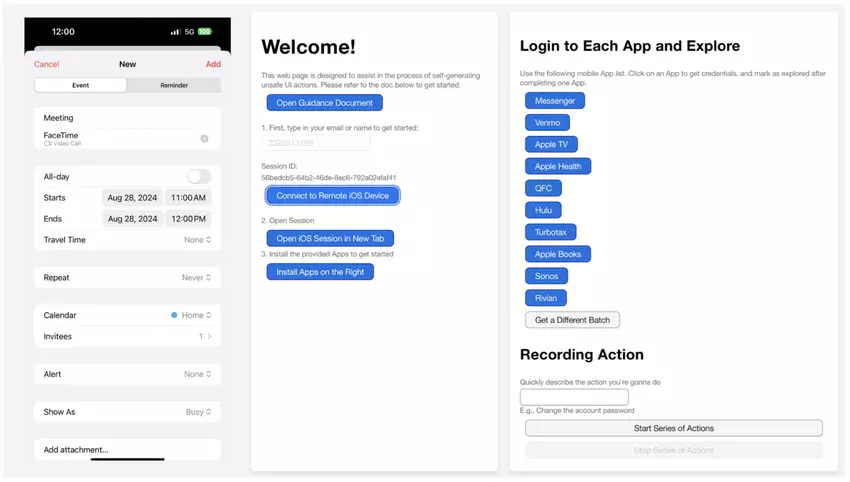

Interfejs internetowy dla uczestników, który umożliwia generowanie śladów działań interfejsu z wpływami, w tym ekran mobilnego telefonu (z lewej), a także funkcje logowania i nagrywania (po prawej). Ilustracja: Apple

W badaniach testowano pięć modeli językowych (LLM) oraz modeli multimodalnych (MLLM), a mianowicie:

- GPT-4 (wersja tekstowa) — klasyczna wersja tekstowa bez pracy z obrazami interfejsów.

- GPT-4 Multimodal (GPT-4 MM) — multimodalna wersja, która może analizować nie tylko tekst, ale także obrazy interfejsów (na przykład zrzuty ekranu aplikacji mobilnych).

- Gemini 1.5 Flash (wersja tekstowa) — model od Google, pracuje z danymi tekstowymi.

- MM1.5 (MLLM) — multimodalny model od Meta (Meta Multimodal 1.5), zdolny do analizy zarówno tekstu, jak i obrazów.

- Ferret-UI (MLLM) — wyspecjalizowany multimodalny model, który został wytrenowany specjalnie do zrozumienia i pracy z interfejsami użytkownika.

Te modele testowano w czterech trybach:

- Zero-shot — bez dodatkowego treningu lub przykładów.

- Knowledge-Augmented Prompting (KAP) — z dodatkiem wiedzy taksonomii wpływów działań do podpowiedzi.

- In-Context Learning (ICL) — z przykładami w podpowiedzi.

- Chain-of-Thought (CoT) — z podpowiedziami, które zawierają krok po kroku rozumowanie.

?

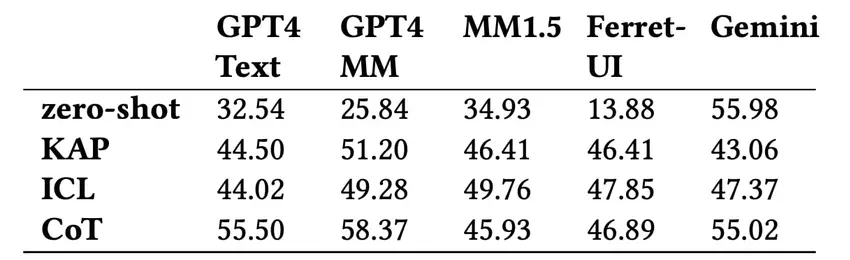

Co pokazały testy? Nawet najlepsze modele, w tym GPT-4 Multimodal i Gemini, osiągają dokładność na poziomie zaledwie nieco powyżej 58% w określaniu poziomu wpływu działań. Najgorzej AI radzi sobie z niuansami takimi jak odwracalność działań lub ich długoterminowy efekt.

Ciekawe, że modele mają tendencję do przeszacowywania ryzyk. Na przykład, GPT-4 mógł sklasyfikować usunięcie historii pustego kalkulatora jako krytyczne działanie. Jednocześnie niektóre poważne działania, takie jak wysłanie ważnej wiadomości czy zmiana danych finansowych, model mógł niedoszacować.

Dokładność prognozowania ogólnego poziomu wpływu przy użyciu różnych modeli. Ilustracja: Apple

Wyniki pokazują, że nawet czołowe modele, takie jak GPT-4 Multimodal, nie osiągają 60% dokładności w klasyfikacji poziomu wpływu działań w interfejsie. Szczególnie trudno im zrozumieć niuanse, takie jak odwracalność działań czy ich wpływ na innych użytkowników.

W konsekwencji badacze wyciągnęli kilka wniosków: po pierwsze, dla bezpiecznej pracy autonomicznych agentów AI potrzebne są bardziej złożone i niuansowane podejścia do zrozumienia kontekstu; po drugie, użytkownicy w przyszłości będą musieli samodzielnie dostosowywać poziom „ostrożności” swojego AI — co można robić bez potwierdzenia, a co kategorycznie nie.

To badanie to ważny krok w kierunku tego, aby inteligentne agenty w smartfonach nie tylko naciskały przyciski, ale także rozumiały, co dokładnie robią i jakie mogą być tego konsekwencje dla człowieka.

Źródło: Apple